La physique quantique

Comprendre la relativité et Histoire

de la physique Quantique

Avant propos:

Qu'est ce que la théorie des Quanta?

Je pense qu'à l'heure actuelle, c'est la théorie humaine la

plus aboutie.

En effet, celle-ci arrive à tout expliquer:

La table périodique des éléments, les réactions chimiques, le

comportement des lasers, les puces électroniques, la stabilité de l'ADN, comment

les particules Alpha quittent le noyau par effet tunnel....

Einstein en dira que c'est une théorie "absconse" et est contraire

au bon sens.

Pauli comparera cette science aux philosophies orientales et

paranormales.

Schrödinger en dira que cette théorie se vérifie toujours.

Pour Planck, c'est une théorie purement mathématique.

Pour Born cette théorie bouleverse la vision du monde.

Avant le XXème siècle beaucoup d'idées sur la physique étaient

difficiles à combattre car par le formalisme elle se vérifiait toujours:

Les lois de la gravitation étaient impeccablement correctes

(Newton 1642 - 1727) ainsi que celles de J C Maxwell sur l'électromagnétisme (1831 - 1897), l'âge de

raison devenait l'âge de la certitude!

Aujourd'hui tout parait sûr pour notre monde macroscopique et

pourtant!

Toutes nos incertitudes de notre monde ont des réponses dans

notre infiniment petit que sont les lois statistiques de la physique quantique

qui bouleversent tous nos concepts rationnels!

Bref, les marmottes risquent de ne plus savoir où elles

campent!

I. Einstein et la notion de relativité :

La découverte la plus

bouleversante que fit Einstein fut sans doute la Théorie de la Relativité. Plus

qu’une simple découverte, il propose une nouvelle manière de penser, de

concevoir l’Univers. Ses recherches furent résolument tournées vers la

relativité des événements, des mesures selon les référentiels. Il prouva que les

notions d’espace et de temps étaient des notions relatives et que l’on ne

pouvait les évoquer sans préciser la référence de mesure. Par exemple la vitesse

de déplacement de la Terre est différente si on la mesure par rapport au soleil

ou par rapport au centre de la galaxie.

Toutefois, une seule mesure et

indépendante de tout référentiel : la vitesse de la lumière dans le vide. Aussi,

de nombreux bouleversements naissent de cette constante. Car si cette vitesse

reste constante quelque soit la vitesse où l’on se déplace pour la mesurer,

c’est bien l’espace et le temps eux-mêmes qui sont variables selon le

référentiel. Le temps et l’espace sont donc bien des notions relatives. Plus

tard Einstein généralise la relativité à l’ensemble des référentiels possibles,

ajoutant donc les mouvements accélérés, achevant ainsi la grande théorie. La

matière apparaît alors comme partie intégrante du tout Espace-temps Matière.

En effet, plus un objet a une

masse importante, plus la force nécessaire pour maintenir une accélération

donnée est importante. De même que précédemment, quelques soient les conditions

dans lesquels s’effectuent les mesures, la lumière a toujours les mêmes

propriétés. C’est alors la masse elle-même qui est modifiée par l’accélération.

Derrière ces concepts assez complexes et abstraits, notre monde est complètement

bouleversé. La géométrie de l’espace et l’écoulement du temps sont modifiés par

la matière.

1.Pourquoi

la « relativité » s’appelle ainsi ?

L’article d’Einstein de 1905 sur

l’électrodynamique des corps en mouvement fonde la relativité sur deux

postulats: que les lois de la physique soient identiques dans tous les systèmes

de référence en mouvement relatif uniforme les uns par rapport aux

autres ( référentiels d’inertie) et que la vitesse de la lumière soit identique

dans tous ces référentiels. Ce principe de relativité, selon lequel les lois

physiques sont indifférentes au référentiel dans lequel on les exprime, est

encore restreint aux mouvements uniformes ( d’ou le nom de relativité

restreinte). Mais il est généralisé par Einstein en 1915 à tous les

référentiels, et plus seulement ceux en mouvement relatif uniforme : la

relativité devient générale.

Le principe de la relativité

signifie en particulier qu’il n’existe aucun référentiel privilégié pour décrire

ces lois, et en particulier que les notions d’espace et de temps absolus de

Newton sont vides de sens. Même si certains peuvent se révéler d’un usage plus

pratique que d’autres, tous les référentiels sont aussi valables que les autres.

Cela n’ouvre nullement la voie à

un quelconque « relativisme philosophique » du genre « il n’y a pas de vérité

absolue, tout se vaut… ». Bien au contraire, utiliser la relativité ( restreinte

ou générale ) signifie rechercher des lois qui restent identiques dans tous les

référentiels…

Concrètement on écrit les

équations de façon covariante ( de sorte que leur forme reste inchangée

dans un changement de référentiel ) et on recherche les invariants, les

quantités qui ne sont pas modifiées dans un changement de référentiel ( par

exemple, l’énergie et l’impulsion d ‘une particule sont modifiées de façon très

précise dans un changement de référentiel et sa masse reste identique ).

2.Les

trois théories successives de la gravitation :

a.

La théorie de la gravitation, ( Newton, 1687) :

Ce qu’il faut savoir de la force de gravitation :

·

La gravitation est une force qui attire deux masses l’une vers

l’autre. Ainsi une pomme tombant d’un arbre est attirée par la Terre, et la

Terre tournant autour du Soleil est attirée par l’astre.

·

La force de gravitation est instantanée. Elle est proportionnelle

au produit des deux masses, et inversement proportionnelle au carré de leur

distance.

·

L’espace préexiste à la matière.

La masse d’un corps est un

facteur qui s’oppose, qui « freine » l’accélération de ce corps par une force

donnée. Donc plus la masse est importante, plus l’accélération sera faible pour

une force donnée :

Ainsi la masse mesure l’inertie

d’un corps, c’est à dire la résistance qu’il oppose à l’accélération

communiquée. Par exemple, un objet en chute libre sur la Terre se voit appliquer

sans cesse d’une force constante : son poids. Si l’on néglige les forces de

frottements dues à l’atmosphère, et d’après Newton, on pourrait constater que

cet objet ne cessera d’accélérer. Or ceci s’oppose à la théorie d’Einstein qui

interdit le dépassement de la vitesse auxquels cas la matière subirait quelques

transformations inhabituelles. En fait cette contradiction est la cause du

mélange entre les théories de la mécanique classique avec la théorie

relativiste. En effet , la masse d’un corps s’approchant de la vitesse de la

lumière devient colossale , puis infinie lorsque cette vitesse est atteinte :

(v² / c²) est toujours inférieur à 1 donc v<c car la racine ne peut être

négative .

Ceci étant impossible , le

dépassement de la vitesse absolue l’est aussi . Soit :

avec mO est la masse de l’objet au repos , v sa

vitesse de déplacement par rapport à nous est m sa masse relative. Mais cette

augmentation ne dépend pas de la masse initiale au repos mais de la vitesse du

corps par rapport à la vitesse de la lumière : 100 kg / (1-(299999²/300000²)^½

=38 730 kg soit une augmentation de plus de 386 fois la masse au repos ! Donc

quand la vitesse du corps tend vers la vitesse de la lumière, sa masse tend vers

l’infini.

De cette conclusion surgit un

remodelage complet de la mécanique classique ; toutes les formes d’énergie

cinétique, potentielle, rayonnement, pression ou même la rotation des astres sur

eux même qui peut froisser localement l’espace deviennent des facteurs

relatifs(toujours par rapport à la constante c) ; par exemple, l’énergie

cinétique s’obtient en faisant la différence de l’énergie d’un corps à la

vitesse v par son énergie au repos ( théoriquement nulle dans un référentiel

donné ). Mais si les vitesses sont faibles par rapport à c, on retrouve la

définition classique de l’énergie cinétique E = ½ m*v², car l’augmentation de

la masse est négligeable.

b. La

relativité restreinte, (Einstein et Poincaré, 1905) :

La vitesse de la lumière dans le

vide est égale à 300 000 Km/s, et cette limite est infranchissable. Matière et

énergie sont équivalentes selon la célèbre formule :

où E est l’énergie, m la masse,

et c la vitesse de la lumière dans le vide. Espace et temps sont intimement

liés : l’Univers a donc quatre dimensions (les trois dimensions de l’espace plus

celle du temps). Elles constituent l’espace-temps.

c.La relativité

générale, (Einstein, 1916) :

Toute masse courbe l’espace

autour d’elle. Les objets se déplacent dans cet espace courbe, et « tombent »

les uns vers les autres. Cette modification de l’espace-temps par la matière se

déplace à la vitesse de la lumière. L’espace n’existe pas de façon absolue.

Chaque corps le modifie et crée de ce fait sa propre géométrie. L’espace est la

somme de toutes ces géométries.

3.

L’univers suivant la théorie de la

relativité générale :

a.

Une équation pour une théorie :

L’équation de la relativité générale s’écrit :

|

Ŕ²/R² - k/R² = ( 8πGρ)/ 3 + λ/ 3 |

Avec : G : constante de gravitation

R : facteur d’échelle(distance entre 2

galaxies)

ρ : densité de matière

λ : constante cosmologique

‘k’ donne le signe de la courbure

De plus on peut regrouper :

·

Ŕ²/R² - k/R² : courbure de

l’Univers

·

( 8πGρ)/ 3 : matière

·

λ/ 3 : énergie du vide

A partir de cette équation on

peut faire des supposition quant à l’avenir de l’Univers.

Les différents scénarios possibles sur le destin de

l’Univers sont :

Ø

sans constante cosmologique : λ=0

·

k=1, l’Univers se contracte et s’effondre sur lui-même. Il se

produit alors un big crunch, phénomène inverse du big bang.

·

k=0, l’Univers est plat, son expansion ralentit indéfiniment sans

jamais s’arrêter.

·

k= -1, l’Univers est ouvert, il continue son expansion à l’infini

Ø

avec constante cosmologique : λ≠0

·

L’expansion de l’Univers serait exponentielle.

b.Effets de la

gravité sur l’Espace-temps :

(8Πk*c¼)*Tμν = Rμν - ½ GμνR

: => L’équation d’Einstein :

Cette équation, au centre de la théorie de la relativité

générale, décrit la gravitation comme une déformation de l’espace temps. La

masse ou l’énergie ( terme de gauche) équivaut à une courbure de l’espace temps

( terme de droite).

Avec : Tμν =

tenseur d’énergie impulsion

Rμν - ½ GμνR

= tenseur d’Einstein

c.Théorie de

l’expansion et loi de Hubble : (cf. : voir 3.1/ )

Prenons de nouveau un phénomène

prédit par la théorie, phénomène étroitement lié au précédent. Notre Univers

peut suivre trois évolutions suivant la masse de matière qu’il contient : si

cette dernière dépasse une valeur critique, l’Univers s’effondrera petit à petit

sur lui-même jusqu’à produire un ‘Big crunch’. Si la masse est égale à cette

valeur, l’Univers est stable. Si elle est inférieure, alors il est en expansion.

Actuellement, et si l’on en croit les calculs des cosmologistes sur la masse

totale de l’Univers, il se produit le phénomène d’expansion. L’Univers n’aurait

donc pas de frontière. Mais il y a toutefois une limite à l’Univers observable.

La loi de Hubble permet en effet de calculer que, à une distance de 15 à 20

milliards d’années-lumière (distance parcourue par la lumière en un an), soit

l’âge de l’univers connu : 15 à 20 G années, les galaxies s’éloignent aussi vite

de nous que leur lumière voyage vers nous. Celle-ci ne peut donc plus nous

atteindre.

|

La physique

quantique

Introduction (I)

A

l'heure actuelle, la "théorie-cadre" de la physique est la mécanique

quantique relativiste. Bien que liée à l'évolution générale de la

physique depuis Newton à Einstein, deux raisons me poussent prudemment à

faire une scission entre l'aspect quantique de la physique et sa

contrepartie relativiste.. Ces

deux aspects de la "théorie-cadre" ont des implications communes, mais

chaque théorie est suffisamment complexe et adulte pour justifier une

étude séparée pour en avoir une bonne compréhension. |

|

La

seconde raison est qu'il n'existe pas encore de théorie quantique relativiste au

sens strict. La relativité restreinte a récemment été quantifiée, mais aucun

mathématicien ni physicien ne peut encore poser les bonnes équations

qu'imposent sa généralisation. Einstein s'en était occupé de 1916 jusqu'en 1955,

l'année où il s'est éteint. Deux générations se sont écoulées depuis sans que

les physiciens parviennent à établir les bonnes équations tellement la théorie

est difficile à formuler.

Le

terme "mécanique" n'est plus du tout approprié à "la quantique" qui englobe

aujourd'hui tous les domaines de la physique et dont les ramifications

s'étendent jusqu’en astrophysique, en biochimie, jusqu'à inclure l'Homme. Malgré

cette évolution le substantif "mécanique" a gardé voix de citer et est assimilé

à celui de "physique" quantique. Aussi, par tradition certains auteurs le

conserve comme titre de chapitre ou l’utilise indifféremment ci et là selon leur

humeur.

Pour

juger objectivement les phénomènes qui obéissent aux lois de la physique

quantique, un résumé de son histoire soulignera le cheminement intellectuel qui

entraîna son introduction dans la physique classique et qui finira par la

remplacer dans le domaine de l'atome. Arrivé à ce point, complété par les

notions de relativité, la distinction entre la physique de Newton, celle

d'Einstein ou de Heisenberg ne fera plus de doute.

Pour

clarifier les notions de physique quantique dont se nourrit dame Nature,

quelques phénomènes en violation avec la réalité viendront conclure cette

introduction, permettant à chacun d'adapter son mode de pensée à ces concepts

tout à fait déconcertants. Les exemples sont éloquents : la dualité de la

lumière, le principe d'indétermination, le paradoxe EPR, les superfluides. Tous

ces exemples appliquent des lois en contradiction avec la physique de Newton et

sont en relation avec l'astronomie et la chimie. Certains physiciens considèrent

que ces phénomènes ont une réversibilité non pas de fait, mais bien de droit.

C'est ici que naissent les paradoxes car ce langage est celui de la physique

classique. Or il est impossible de traiter la physique quantique comme une autre

science car les explications butent encore trop souvent sur notre interprétation

de la “réalité”. Nous insisterons longuement sur ce thème. Le physicien fait

alors appel à la philosophie pour tenter de comprendre un monde phénoménologique

qui lui échappe. Dans ce sens le monde que décrit la physique quantique nous est

voilé. Mais gardons-nous de le considérer comme le seul domaine paradoxal de la

nature.

Les

prémices

|

Devant les prodigieuses avancées des sciences et des techniques au cours du

XIXe

siècle, le chimiste français Marcellin Berthelot s’était

exclamé : “il n’y a pas un problème que la science ne puisse résoudre”.

Lord Kelvin (William Thomson) avait ressentit la même impression et

considéra vers 1852 que : “la physique avait fourni une description

cohérente et a priori complète de l’univers”. Malheureusement ces

certitudes étaient basées sur une vision bien naïve du monde, un monde

considéré comme stable et éternel. La Science ne se souciait guère des

aspects négatifs des découvertes, elle ne posait pas de questions sur son

origine, ses retombées, son éthique. Que devenait dans ce monde simple et

sans mystère, les paradoxes, la conscience, la dimension transcendante du

monde, le non-sens ?

|

|

|

Lord Kelvin. |

La

philosophie des sciences

Comment

avons-nous appris que la théorie classique ne s’appliquait pas à toute la

réalité ? La physique quantique apparut suite aux difficultés que rencontrèrent

les chimistes et les physiciens du siècle dernier pour expliquer certains

phénomènes naturels. Les théories concernant les différents états de la matière,

la chaleur spécifique ou la réaction des métaux photosensibles ne suivaient pas

les courbes standards. Si les savants avaient bien trouvé des formules pour

prédire ces événements, certains corps s'écartaient obstinément des valeurs

moyennes pour des raisons qui restèrent longtemps mystérieuses. C'est la

thermodynamique qui donna le coup d'envol de la résolution de ces problèmes.

Mais elle-même enchâssée dans le carcan de la philosophie séculaire et

contrainte par la physique classique eut de grosses difficultés pour évaluer la

portée de la nouvelle mécanique quantique.

|

Les acteurs (I) |

|

|

|

|

Amedeo Avogadro, Joseph Louis Gay-Lussac

et Robert Boyle. |

|

Jusqu'au XXe

siècle, la matière n'intéressait pas les physiciens. Cette

science était réservée aux chimistes parmi lesquels nous retrouvons les célèbres

Avogadro, Gay-Lussac, Boyle et tant d'autres. L'Encyclopedia Britannica

publiée en 1771 considérait que les atomes étaient les plus petits corps

naturels indivisibles.. Or depuis Démocrite

on avait déjà remarqué que certains atomes ou plutôt certaines molécules étaient

structurées et présentaient des formes variées et qu'aucunes d'elles ne

pouvaient se transformer en une autre. L'or et le plomb pouvaient bien

s'amalgamer mais il était toujours possible de les séparer par l'action de la

chaleur. Cette définition était donc incomplète et suscita l'intérêt des

chercheurs.

Vers

1774 Antoine Laurent de Lavoisier découvre que les corps composés tels que l'air

ou les minéraux sont constitués d'éléments simples, mélangés dans des

proportions bien déterminées. Lavoisier découvrit 23 éléments chimiques simples.

Il est à juste titre considéré comme l’un des créateurs de la chimie moderne. Il

faudra attendre une génération pour que John Dalton propose le concept atomique en 1803 : il considère que la matière est constituée

de molécules qui sont elles-mêmes composées d'atomes indivisibles. Vers 1860,

August Kekulé von Stradonitz et Butlerow démontrent grâce à la lumière polarisée

que les molécules des gaz obéissent à un comportement structurel particulier, ce

qui leur permettra d'échafauder les principes de l'architecture chimique. C'est

également Kekulé qui précisa le sens des termes d'atomes et de molécules dans

leur définition moderne.

Neuf

ans plus tard Dimitri Mendéléev

proposa une classification des éléments selon leur masse atomique mais il ne put

expliquer les relations entre classes d'éléments. Il faudra attendre quelques

générations pour découvrir les propriétés électriques des atomes et leur

architecture. En 1874 Jacobus van 't Hoff et indépendamment de lui Joseph Le Bel

découvraient que la stéréochimie expliquait les isomères des molécules

organiques.

En 1887

Joseph J.Thomson démontra que le courant électrique qui pouvait se propager dans

un gaz était associé à des particules chargées négativement. En soumettant

celles-ci à un champ magnétique et en observant les déviations des particules,

il pouvait connaître leur charge et leur masse avec précision.

La fin

du siècle fut marquée la découverte des rayons X (Roentgen, 1895) ainsi que de

la radioactivité naturelle (Becquerel, 1896). En 1903, les physiciens anglais

Ernest Rutherford et Frederick Soddy

découvrirent que la radioactivité naturelle était une transmutation d'un atome

dans un autre. Ainsi, les atomes radioactifs pouvaient émettre des particules

positives (rayonnement

a,

un atome d'hélium deux fois ionisé), négatives (rayonnement

b,

des électrons) ou des ondes de très courtes longueurs d'ondes (rayons

g).

Mais il restait à localiser les composantes du rayonnement á et en corollaire

celles du noyau. Quatre ans plus tard, J.J.Thomson

proposa un modèle atomique dans lequel les charges négatives - les électrons -

étaient distribués dans une matrice chargée positivement. Pour respecter la

neutralité de la matière, les électrons devaient avoir exactement les mêmes

valeurs que les charges positives.

Entre-temps

les chimistes et les physiciens ont essayé d'évaluer la dimension des molécules

et de déterminer la nature des forces qui les maintenaient ensembles. Mis à part

les auteurs précités, les travaux les plus concrets et qui témoignent d'une

ébauche de solution sont ceux de R.Brown sur le mouvement brownien datant de

1828 et de R.Clausius en 1857 qui fit la distinction entre les différents états

solides, liquides et gazeux

en fonction de l'agitation moléculaire. Ces travaux seront souvent discutés et

critiqués en termes d'entropie et de leur cohérence vis-à-vis des lois

classiques. Il était évident aux yeux de Planck, Boltzmann ou Sommerfeld que les

phénomènes naturels et en particulier la loi d'entropie ne pouvait être réduite

à des phénomènes purement mécaniques. Ces recherches se termineront avec la

célèbre thèse de doctorat d'Einstein en 1906.

|

Equation d'Einstein du mouvement brownien

|

|

|

|

<x2>

la valeur quadratique moyenne du déplacement par rapport à l'origine

|

|

R, la

constante des gaz

a, le

rayon des molécules-sphères

T, la

température |

h

, la viscosité

N, le

nombre d'Avogadro,

t , le

temps écoulé depuis l'instant 0. |

|

Ainsi

pour de l'eau à 17°C et t=1 min, a = 0.001mm et

√<x2> = 6 µm.

|

|

On savait alors que le rayon de l'atome d'hydrogène oscillait

entre 1 et 2x10-8

cm et l'on estima le nombre d'Avogadro N à environ 6.02 x 1023

molécules par mole. Peu de temps après la publication de cette formule, Einstein

établit une correspondance entre le mouvement brownien isolé et la diffusion

d'un ensemble de particules. Einstein voulait ignorer les détails des phénomènes

de collisions et traita la diffusion comme un processus de Markov

.

Sa

théorie sera appliquée avec succès dans tous les domaines exploitant les

propriétés d'élasticité, de viscosité et d'écoulement de la matière, en bref la

rhéologie. Son travail touchera l'industrie du bâtiment (le ciment), la

météorologie (les aérosols) ainsi que les secteurs touchant à la minéralogie et

la chimie alimentaire.

A côté

de la détermination de la dimension des molécules, les physiciens étaient

également préoccupés de savoir comment le mouvement se transmettait dans la

matière. Les physiciens savaient depuis longtemps, depuis qu'ils avaient observé

un morceau de bois flotté à la surface de l'eau, qu'une onde ne consistait pas

en un déplacement de la matière mais bien à un mouvement dans celle-ci.

|

On démontre ce principe quotidiennement par de nombreux mobiles, dont

celui des billes suspendues en contact les unes avec les autres. En

lançant la première bille sur la deuxième, quasi instantanément le choc se

propage à travers les autres billes provoquant le déplacement de la

dernière. Toutes les billes situées entre les deux extrémités restent

immobiles. La propagation se transmet de bille à bille, en d'autres termes

une certaine quantité d'énergie se propage dans la matière à une vitesse

finie. |

|

Le même

phénomène explique la propagation du son dans l'air. Ainsi, qu'elles soient

électromagnétiques ou élastiques, les ondes obéissent à une relation de

propagation appelée la fonction d'onde.

|

La

fonction d'onde

|

|

Une

onde qui se propage dans l'espace (x,y) et dans le temps (t) suit une

sinusoïde qui obéit à la relation :

y = a sin ( wt

+ f )

avec a,

son amplitude

w,

sa vitesse angulaire (2

)

f,

l'angle de phase

Son

intensité est égale au carré du module de son amplitude, soit |a|2.

Ainsi la lumière visible présente une fréquence

n ~

3x1015

cycles/sec ou 3x1014 Hz. |

|

|

|

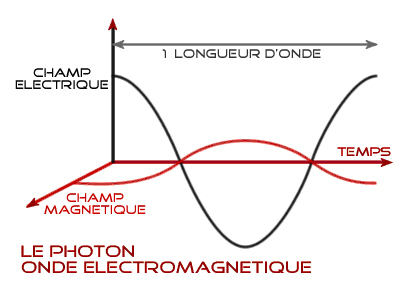

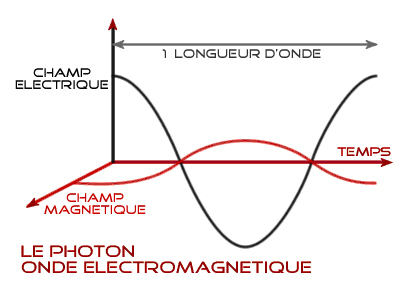

Onde :

champ électrique (E) et magnétique (B) qui oscillent ensembles. L’un

des champs pris

isolément ne peut créer cette structure particulière d’onde.

|

|

Au XIXe

siècle grâce aux travaux de Maxwell, les physiciens connaissaient son équation

généralisée aux différentielles partielles, sur laquelle nous nous

reviendront plus tard.

|

Une énergie quantifiée (II)

En 1900 Max Planck rédacteur en chef de l'édition allemande des Annales

de Physique découvre des contradictions en étudiant le rayonnement

d'un point de vue ondulatoire, sur base de la mécanique de Maxwell et des

travaux de Hertz. Nous savons tous que le fer chauffé à blanc rayonne dans

le visible entre 600 et 2000°C. Mais la théorie ondulatoire du rayonnement

qui prévalait depuis les démonstrations de Fresnel, Fizeau et Foucault ne

pouvait pas à la fois rendre compte des observations dans l’ultraviolet et

dans l’infrarouge. La formule ondulatoire impliquait que l'énergie du

rayonnement ultraviolet devait être infinie. |

|

Tous

les savants savaient que le Soleil n’émettait pas une énergie de plus en plus

intense à mesure que la fréquence du rayonnement augmentait, tout comme un

tisonnier ne rayonnait pas de plus en plus fort à mesure que son éclat

augmentait; il existait un maximum au-delà duquel l’intensité du rayonnement

chutait. La formule fonctionnant pour toutes les fréquences plus basses, le

physicien viennois Paul Ehrenfest parla bientôt de "catastrophe ultraviolette".

Une autre formule développée par lord J.Rayleigh et James Jeans

expliqua bientôt le rayonnement ultraviolet mais ne s'appliquait plus aux basses

fréquences ! Quel lien y avait-il entre la fréquence et le niveau d'énergie ?

|

La loi

d'équipartition

La loi

exponentielle de Wien s'applique aux basses fréquences :

r

= an3e-bn/T

avec a,b

constantes

La loi

de Rayleigh s'applique aux hautes fréquences :

r(n,T)

= c1v2T

e-c2n/T

L'énergie d'équilibre U suit la relation :

U = kBT,

kB étant la constante de Boltzmann

La loi

d'équipartition ne peut expliquer de façon rigoureuse le lien qui existe

entre la fréquence et le niveau d'énergie. Il faudra attendre les

explications de Planck et d'Einstein basées sur la théorie quantique.

|

Les

signes avant-coureurs d'une erreur de formulation dans la loi d'équipartition

aux hautes fréquences arrivèrent dans les laboratoires de physique.. A Berlin, Planck essaya de trouver une formule hybride qui

réunirait les deux précédentes. Il finit par découvrir expérimentalement que

l'action (l'énergie) ne pouvait varier que par quantité finie en fonction de la

fréquence, obéissant à une constante de proportionnalité, h, égale à 6.625 x 10-34

Joule.sec

. La constante de Planck était née!

Planck

créa le concept du quantum d'action, produit d'une énergie par le temps, quantum

que G.Lewis baptisera "photon". Einstein compléta cette définition en découvrant

que l'énergie d'une onde de fréquence

n

est donnée par la formule E =

n .

Les quantités d'énergie devenaient discontinues !

.

Les quantités d'énergie devenaient discontinues !

L'introduction de quantités discrètes dans un phénomène jugé continu bouleversa

tout le monde de la physique et M.Planck lui-même, qui tenta un certain temps de

rejeter sa propre théorie. Bien que cette "constante de Planck",

,progresse par pas infime, on peut comprendre la révolution qu'elle allait

entraîner. 1 Joule représente l'énergie acquise par une masse de 1 kg tombant de

10 cm. Infiniment plus faible, 1 eV représente l’énergie acquise par un électron

au repos porté à la vitesse de 600 km/s. Insignifiante dans le monde qui nous

entoure, la constante de Planck apparaît dans toute sa réalité dans les

processus à l'échelle de "

,progresse par pas infime, on peut comprendre la révolution qu'elle allait

entraîner. 1 Joule représente l'énergie acquise par une masse de 1 kg tombant de

10 cm. Infiniment plus faible, 1 eV représente l’énergie acquise par un électron

au repos porté à la vitesse de 600 km/s. Insignifiante dans le monde qui nous

entoure, la constante de Planck apparaît dans toute sa réalité dans les

processus à l'échelle de " ",

c'est-à-dire dans toutes les interactions nucléaires. Le phénomène était si

contrariant qu'il fallut attendre 17 ans pour que M.Planck accède au prix Nobel

pour cette découverte fondamentale et ses travaux ultérieurs. Aujourd'hui,

l'aspect quantique du rayonnement est reconnu mais sa formulation reste encore

largement discutée.

",

c'est-à-dire dans toutes les interactions nucléaires. Le phénomène était si

contrariant qu'il fallut attendre 17 ans pour que M.Planck accède au prix Nobel

pour cette découverte fondamentale et ses travaux ultérieurs. Aujourd'hui,

l'aspect quantique du rayonnement est reconnu mais sa formulation reste encore

largement discutée.

Si le

quantum d'action est l'unité élémentaire d'énergie, la loi d'équivalence

d'Einstein implique qu'il existe également une masse minimale. En fait, cette

relation signifie en corollaire que la matière ne peut pas se décomposer à

l'infini, de la molécule à l'atome, de l'atome au quark et à je ne sais quelle

entité minimale. " "

signifie qu'il existe une énergie minimale, c'est-à-dire une masse limite, non

ponctuelle, en-dessous de laquelle il n'existe rien. Nous pouvons déjà donc

prédire que notre obstination réductionniste sera un jour interrompue dans sa

recherche de l'infini petit, probablement entravée à l'échelle des quarks, non

seulement par l'échelle de Planck mais aussi par le principe d'incertitude dont

nous reparlerons.

"

signifie qu'il existe une énergie minimale, c'est-à-dire une masse limite, non

ponctuelle, en-dessous de laquelle il n'existe rien. Nous pouvons déjà donc

prédire que notre obstination réductionniste sera un jour interrompue dans sa

recherche de l'infini petit, probablement entravée à l'échelle des quarks, non

seulement par l'échelle de Planck mais aussi par le principe d'incertitude dont

nous reparlerons.

Et si

la constante de Planck était nulle? Hé bien, le monde

quantique ne serait plus ce qu’il est. Les interactions entre systèmes

microscopiques obéiraient aux lois classiques de la mécanique newtonienne ou de

la relativité et l’atome de Bohr reprendrait du service. Il tournerait autour du

noyau puis… s’effondrerait !

Une

autre preuve de la réalité de l’existence de

concerne l'effet photoélectrique. Alors que Planck venait de poser le concept du

quantum, le photon, et que bien peu de chercheurs le suivait dans cette démarche,

Einstein lui donna une réalité tout à fait physique en expliquant de quelle

façon les électrons véhiculaient l'énergie.

concerne l'effet photoélectrique. Alors que Planck venait de poser le concept du

quantum, le photon, et que bien peu de chercheurs le suivait dans cette démarche,

Einstein lui donna une réalité tout à fait physique en expliquant de quelle

façon les électrons véhiculaient l'énergie.

L'effet

photoélectrique fut découvert en 1887 par le physicien allemand Heinrich Hertz

qui découvrit qu'en illuminant deux surfaces métalliques sous tension au moyen

d'une lampe à arc il se produisit une étincelle électrique entre les plaques.

Deux ans plus tard, le hongrois Philippe Lénard et M.Wolf

confirment son observation grâce à des expériences sur le rayonnement

monochromatique et suggèrent que la lumière ultraviolette peut expulser des

grains de matière des surfaces métalliques. Il faudra attendre 1899 pour que

J.J.Thomson

comprenne que l'effet

photoélectrique induit par

la lumière ultraviolette était provoqué par l'émission d'électrons.

C'est

Lénard en 1902 qui trouva le début de l'explication : l'énergie des électrons

écrit-il "ne dépend d'aucune manière de l'intensité lumineuse".

Mais c'est Einstein

en 1905 qui trouva la bonne explication en se basant sur un principe heuristique,

en dégageant des règles à partir de ses recherches et de ses découvertes. Il

démontre que le quantum d'action représente une quantité d'énergie discontinue

qui peut être transmise aux électrons d'un métal. Puisque cette énergie est

constante à la source, la vitesse des électrons l'est aussi. Quelle que soit

l'intensité initiale des photons et la nature du matériau irradié,

l'amplification est linéaire; les électrons qui s'échappent de la surface

métallique se De l’usage de la constante de Planck propagent toujours avec la

même vitesse et la même énergie.

Einstein considère que la lumière se comporte comme un flux de particules qui

bombarde la surface métallique : plus la fréquence du rayonnement est élevée

plus l'énergie est importante.

Einstein fixe également plusieurs limites à l'effet photoélectrique :

- La

règle de Stokes : la fréquence du rayonnement photolumineux est toujours

inférieure à celle de la lumière incidente.

-

L'énergie de photo-ionisation d'un électron ne peut excéder l'énergie de la

lumière incidente,

n.

n.

-

L'effet Volta et la limite de Duane-Hunt : un tube à rayons X fonctionnant à un

potentiel V possède une limite supérieure de fréquence qui obéit à la relation

eV =  n.

n.

La

théorie des quanta imaginée par Planck sera parfaitement appliquée par Einstein.

La découverte de l'effet photoélectrique conduira à de nombreuses appareils de

détection: le compteur à gaz, le compteur à scintillations,

les photomultiplicateurs d'images et les dosimètres thermoluminescents (DTL)....

|

La

formule de Planck |

|

|

|

L'équation de la répartition du rayonnement du corps noir - de la

densité spectrale

r - en équilibre

thermique est uniquement fonction de la fréquence

n

et de la température T.

Elle est indépendante de la nature du corps.

est la constante de Planck, k la constante de Boltzmann, c la vitesse

de la lumière. On retrouve la loi de Wien si

est la constante de Planck, k la constante de Boltzmann, c la vitesse

de la lumière. On retrouve la loi de Wien si

n/kT

>> 1 . n/kT

>> 1 .

|

|

L'équation de l'énergie du rayonnement |

|

E =

n

- P n

- P |

|

L'énergie E libérée par des électrons arrachés à une surface

métallique irradiée par une lumière de fréquence í explique l'effet

photoélectrique. |

|

L'équation des chaleurs spécifiques |

|

|

|

La

chaleur spécifique cv d'un atome-gramme d'un solide

cristallin ne dépend que du choix de la fréquence

n.

La fréquence est également appelée "température d'Einstein", TE

, lorsque z

= 1. R est la constante des gaz.

|

|

La

constante de Rydberg

|

|

|

|

Lorsque

R est placée dans l'équation de Niels Bohr concernant la structure

atomique, on découvre que les électrons parcourent des orbites fermés

sans émettre d'énergie. On ne peut plus généraliser la loi

d'équipartition.

est placée dans l'équation de Niels Bohr concernant la structure

atomique, on découvre que les électrons parcourent des orbites fermés

sans émettre d'énergie. On ne peut plus généraliser la loi

d'équipartition.

|

|

La troisième apparition du quantum d'action concerne le problème de la chaleur

spécifique.

Depuis 1840, les chaleurs spécifiques du carbone, du bore et du silicium à

température ambiante étaient trop faibles. Ces corps solides ne satisfaisaient

pas à la relation entre chaleur spécifique et poids atomique. La chaleur

spécifique du diamant par exemple oscillait d'un facteur 3 entre 0 et 200°C et

d'un facteur 15 entre -100 et 1000°C ! Cette différence n'était pas accidentelle.

Cette anomalie était encore plus étrange pour les gaz.

En

novembre 1906 Einstein

publia un article sur les chaleurs spécifiques dans lequel il présenta le

premier graphique qualitatif basé sur les expériences de H.Weber sur le diamant.

Il expliqua que la chaleur spécifique æ était induite par un effet quantique qui

obéissait à la relation :

Lorsque

z

=1, la valeur de la température T est baptisée "température d'Einstein", TE,

et se manifeste pour TE

= 1300°K ce qui est en parfait accord avec la courbe

quantique de l'état solide du diamant.

Quelques années plus tard Einstein analysa les aspects dynamiques et

statistiques du problème. Il généralisa le calcul des chaleurs spécifiques tout

d'abord aux corps solides (1907) puis aux gaz (1913) C'est ainsi que l'on compris pourquoi des substances légères comme le diamant

présentaient des effets quantiques à température ordinaire.

C'est

en 1905 qu'Einstein pose la relation d'équivalence entre masse et énergie :

E = mc2

Cette

équation signifie que le champ d'énergie produit par une particule au repos est

égal à la masse de cette particule, au facteur c près. En suspend, cette

équation implique que la masse d'une particule qui se déplace à la vitesse de la

lumière se transforme en énergie, ou plus exactement, il faut considérer que

dans ses conditions sa masse n’est plus une inertie à vaincre mais plutôt une

énergie qui ne cesse d’augmenter .

La

loi de conservation de l'énergie (en Relativité)

Dans

d'autres conditions bien déterminées, cette particule émettra un rayonnement de

fréquence

n,

obéissant à la constante de Planck, tel que :

Ainsi

donc Einstein offrit à Planck une confirmation de la réalité du quantum d'action,

le photon et de la nature quantique de la lumière.

|

La conception atomique de Bohr (III)

En 1910, Rutherford tente de trouver une théorie qui expliquerait les

propriétés de l'atome. Il remarque en projetant un rayonnement á sur

différents matériaux que celui-ci est diffusé sous certains angles bien

définis et même renvoyé vers la source, comme s'il existait un point

matériel au centre de la matière sur lequel le rayonnement rebondissait.

Cette observation était tout à fait inattendue. Le modèle atomique de

Thomson précisait que les particules

a

devaient traverser le noyau et ne subiraient que de faibles déviations par

les charges positives. |

|

Pour

expliquer cette collision élastique, en 1917 Rutherford propose une thèse

planétaire de l'atome qui s'articule autour des propriétés électriques de la

matière. Celle-ci est rassemblée dans un noyau de très petite dimension, environ

10-14 m de rayon, chargé d'électricité positive autour duquel gravite

dans un grand espace vide les électrons négatifs découverts par Thomson. En

appliquant les lois de l'électromagnétisme de Maxwell, cet atome (son électron)

devait rayonner sur toutes les fréquences, offrant un spectre continu.

Or,

quelques années plus tôt, en 1884 le suisse Johann Balmer

avait découvert des raies spectrales dans le spectre visible émis par l'atome

d'hydrogène (la série de Balmer). Il démontra que leur présence en des endroits

bien déterminés du spectre appliquait une sorte de loi universelle : la série de

raies de l'atome d'hydrogène s'obtenait en divisant la fréquence de chacune

d'elle par le carré d'un nombre premier, n, le premier des nombres dit "quantiques".

De façon générale, pour l'ensemble des raies, dont celles n'appartenant pas au

spectre visible cette relation empirique s'écrit

:

avec

l,

la longueur d'onde

RH,

la constante de Rydberg = 1.097x107 /m

Pratiquement, pour nf

= 2 et ni

= 3,

l

= 656 nm, c'est la fameuse longueur d'onde de l'hydrogène-alpha bien connue des

astronomes qui baigne de nombreuses nébuleuses

dans un halo rouge et permet également d'étudier l'activité de la chromosphère du

Soleil.

Le

modèle atomique de Rutherford traduit que tout atome contient le même nombre de

protons que d'électrons, c'est le numéro atomique du tableau de Mendéléev. Il

explique aussi les transitions atomiques qui provoquaient les raies spectrales.

Ainsi, un certain ordre naturel se retrouvait tant dans l'orbe des planètes que

dans la structure microscopique de l'atome. Cette relation n'est certainement

pas fortuite car elle conduisit à la formation de la matière et à l'agencement

de l'univers.

Mais en

1911 dans le laboratoire de Rutherford à Cavendish, le physicien danois Niels

Bohr fit remarquer que dans son mouvement circulaire l'électron devait s'épuiser

en émettant autant d'énergie et finirait inévitablement par tomber très

rapidement sur le noyau au bout d'une fraction de seconde (10-8

sec). D'un autre côté, le noyau et l'électron étant de

charges opposées, la force d'attraction électrique devait agir entre eux. Dès

lors, la moindre perturbation orbitale provoquerait l'annihilation de l'atome en

moins de 10-17

sec ! La théorie devait donc s'incliner devant les faits de

l'expérience.

Si les

ondes stationnaires sont des multiples et des sous-multiples de la longueur

d'onde, cela revient à dire que la longueur d'onde de l'orbitale de l'électron

(2pr)

est un multiple entier de celle-ci. Exprimé en termes cinétiques et quantiques

la formule précédente s'écrit :

Dès

lors la circonférence de l'orbitale de l'électron vaut (nl)

ou exprimée sous forme cinétique:

Bohr

reprit le concept d’Einstein consistant à dire que le rayonnement transportait

des quanta d’énergie. Il reconnaissait ainsi la validité de la constante de

Planck et des observations de Balmer. C’est ainsi que Bohr se demanda en 1913 si

les raies du spectre ne pouvaient pas s'exprimer selon des proportions simples

Dans

son état fondamental l'atome n'émet pas de photon. Mais dès qu'il change

d'orbitale, il absorbe ou émet une énergie proportionnelle à

.

Jusqu'ici la formule inventée par John Nicholson sera appliquée avec

clairvoyance par Bohr. On y retrouve l'intégrale qui définit le mouvement des

particules comme étant égale à la constante de Planck multipliée par un nombre

quantique. Puisque

.

Jusqu'ici la formule inventée par John Nicholson sera appliquée avec

clairvoyance par Bohr. On y retrouve l'intégrale qui définit le mouvement des

particules comme étant égale à la constante de Planck multipliée par un nombre

quantique. Puisque

n

=

n

=  c/l,

on retrouve également le résultat empirique de Balmer. Cette formule de

Nicholson-Bohr conduira à l'équation finale de Dirac.

c/l,

on retrouve également le résultat empirique de Balmer. Cette formule de

Nicholson-Bohr conduira à l'équation finale de Dirac.

Représentation d'une Onde:

(Notons aussi que la "porteuse" d'onde est toujours égale

à c, soit la célérité de la lumière: 300 000 000 m/s.

Il ne fait pas la confondre avec les différentes

harmoniques dues aux absorptions et émissions électroniques fonctions des

oscillations des électrons sur ses couches superficielles.)

Bohr

supposa également que chaque raie correspondait à un saut de l'électron en

fonction de son énergie. Il postule que les électrons ne peuvent graviter que

sur certaines orbitales, en provoquant des émissions discrètes d'énergie. Pour

empêcher l'électron de s'écraser sur le noyau, il impose une orbite

fondamentale r n , en-dessous de laquelle l'électron ne peut pas tomber.

Cette formule est déduite des relations précédentes et de la seconde loi de

Newton (F =

ma) où "F" représente la

force électrique (kZe²/r²). Cette loi permet d'aboutir à une relation cinétique

qui exprime le rayon de l'orbitale de l'électron en fonction du nombre quantique

principal, n. Dans cette équation le quantum d'action

=

=

/2p,

mais il est plus commode de le représenter par la constante de Planck, Z étant

le nombre de protons. Ce "rayon de Bohr" est égal à :

/2p,

mais il est plus commode de le représenter par la constante de Planck, Z étant

le nombre de protons. Ce "rayon de Bohr" est égal à :

Le

résultat de Bohr permet du même coup de connaître l'énergie minimale que

l'électron pouvait avoir. Dans son état fondamental son énergie Eo

vaut :

Bohr

conserve la loi de la conservation de l'énergie d'Einstein en stipulant que

l'énergie gagnée ou perdue (Ei,

Ef)

par un électron lorsqu'il change d'orbitale se transforme en une absorption ou

une émission d'un photon d'une fréquence

n

déterminée, telle que :

ni,f

= Ei - Ef

ni,f

= Ei - Ef

Mais en

1896 le physicien hollandais Pieter Zeeman découvrit que chaque raie pouvait

être composée de plusieurs raies plus fines appelées doublets et triplets,

observation confirmée plus tard par Johannes Stark (1913) et Karl Schwarzschild

(1916). Cette "structure fine" comme elle sera baptisée n'était pas décrite dans

le modèle original de Bohr. De plus celui-ci ne permettait pas à l'électron de

graviter sur des trajectoires non circulaires, limitant ses degrés de liberté à

une seule variable, n. Cette théorie n'était donc pas complète.

En 1915

Arnold Sommerfeld introduit un second nombre quantique l, dit nombre

quantique secondaire, pour permettre à l'électron de graviter sur des orbitales

elliptiques. Il découvrit également une formule relativiste qui confirmait la

structure fine de l'atome. Mais cette théorie, tout comme celle de Bohr ne

tenait pas compte de l'intensité des raies. La formule de Bohr indiquait un trop

grand nombre de raies par rapport aux analyses de spectroscopie. Il fallait

trouver une méthode pour réduire l'intensité de certaines d'entre elles à zéro.

Bohr

fit une analyse astucieuse des raies d'émission de l'atome en exploitant les

sauts d'énergie quantiques. Il mélangea les théories de Newton (l'orbite de

l'électron) et les lois quantiques de Planck ("sauts" d'orbites). Le mouvement

de l'électron engendrant un champ magnétique, il introduisit un nombre quantique

magnétique m, appelé magnéton. Les séries de raies n'obéissant plus tout à fait

à sa loi, Bohr établit une correspondance entre les fréquences observées et

celles déterminées par son calcul quantique. En 1918 sa théorie planétaire de

l'atome doit s'adjoindre un "principe de correspondance", que d'aucun considère

comme trop artificiel, Werner Heisenberg en particulier. Les physiciens

reprochaient à Bohr de chercher à tout prix à maintenir sa théorie. Son principe

de correspondance était trop imprécis et certaines raies imposaient le produit

de trois nombres quantiques successifs (n, l, m) qu'il ne pouvait plus

expliquer.

S.Goudsmit et G.Uhlenbeck reprirent alors la conception planétaire de la

structure de l'atome. L'effet Zeeman résultant en première approximation des

mouvements orbitaux des électrons, le mouvement d'un atome devait

obligatoirement être lié à sa charge électrique et à sa masse. Or la

spectroscopie indiquait l'existence d'effets Zeeman anormaux, que ni la théorie

classique ni la théorie quantique ne pouvaient expliquer. Théoriquement

cependant, Einstein et Barnett

avaient déjà démontré quelle devait être la grandeur du rapport entre le moment

magnétique et le moment cinétique

de l'électron. On savait également depuis les travaux de Faraday et de Maxwell

que la magnétisation d'un barreau de fer entraînait sa mise en rotation et

inversement, c'est le gyromagnétisme. Les effets Zeeman anormaux étaient

justement considérés comme des anomalies "gyromagnétiques".

En 1925

Goudsmit et Uhlenbeck émettent l'idée que l'électron dispose d'un magnétisme propre et est animé d'un

mouvement de rotation sur lui-même. Ils proposent que l'électron, comme une

planète sur son axe, peut tourner dans un sens ou dans un autre, mouvement

qu'ils dénommèrent le spin. Sa grandeur était égale aux prédictions : le

moment cinétique de l'électron était égal à 1/2

.

Son action pouvait induire certaines raies spectrales non expliquées par la

théorie planétaire de Bohr. Le nombre de spin sera le quatrième nombre quantique,

s, valant +1/2 ou -1/2 selon les cas (seuls les bosons ont un nombre de

spin égal à une valeur entière de

.

Son action pouvait induire certaines raies spectrales non expliquées par la

théorie planétaire de Bohr. Le nombre de spin sera le quatrième nombre quantique,

s, valant +1/2 ou -1/2 selon les cas (seuls les bosons ont un nombre de

spin égal à une valeur entière de

)

.

)

.

Mais la

théorie de Bohr éluda totalement les propriétés ondulatoires de la lumière. Les

phénomènes d'interférences de phases et d'amplitudes s'accordaient mal avec le

concept de corpuscule, sans oublier que l'explication de la structure fine

restait incomplète.

|

La structure

électronique de l'atome (IV)

Armé de tout cet arsenal théorique, comment peut-on représenter un atome ?

Prenons l'atome d'hydrogène pour exemple, composé d'un seul proton et d'un

seul électron. Au repos, son unique électron orbite à une distance bien

précise, un des quatre nombres "quantiques" obéissant à la constante de

Planck et à la théorie de Bohr. Ce nombre quantique principal est

représenté par la lettre n et défini à lui seul tous les états

d'énergie de l'atome : |

|

Le

niveau fondamental de l’électron (où n = 1) est fixé à 0.53 Å du noyau. Il est

prouvé mathématiquement par cette fameuse équation de Schrödinger, une équation

aux différentielles triples, la première que les étudiants apprennent à

démontrer au cours de chimie supérieur.

Mais

plutôt que d’orbitale, nous devrions parler de couche fondamentale ou de nuage

électronique occupé par l’électron. Les lois de la physique quantique stipulent

que ce nuage est sphérique et centré sur le noyau. C'est la couche k

également appelée état 1s. Si un seul nombre quantique suffit à

déterminer l'énergie et le moment cinétique de chaque état d'un atome, la

résolution de l'équation de Schrödinger permet de démontrer que le moment

cinétique L est lié à un second nombre quantique indépendant, le nombre

quantique orbital l par la formule :

L = √ [

l

(l

+ 1)

] avec

l = 0,1,2,3... n-1

] avec

l = 0,1,2,3... n-1

où " "

représente la constante de Planck. Puisque la valeur absolue du carré de la

fonction d'onde |Y|2

mesure la probabilité de localiser l'électron en un point "r" de l'espace, pour

n = 1 et l = 0, les fonctions d'ondes associées à ces états

électroniques présentent une symétrie centrale, l'électron ayant toutes les

chances de se trouver dans le noyau (r = 0).

"

représente la constante de Planck. Puisque la valeur absolue du carré de la

fonction d'onde |Y|2

mesure la probabilité de localiser l'électron en un point "r" de l'espace, pour

n = 1 et l = 0, les fonctions d'ondes associées à ces états

électroniques présentent une symétrie centrale, l'électron ayant toutes les

chances de se trouver dans le noyau (r = 0).

Au

premier état d'excitation, grâce à un apport d'énergie de 13.6 eV

, l'électron passe sur la seconde couche permise l, située à 2.12 Å du

noyau (22

x 0.53). Le nuage électronique s'étend et prend l'aspect non plus d'une sphère

mais de deux lobes qui ne sont plus connectés radialement à l'état fondamental,

c'est l'état 2p. Cette seconde couche, comme toutes les suivantes sont

divisées en sous-couches (s, p, d, f, etc), déterminées par le nombre quantique

orbital.

Lorsque

l'atome est soumis à champ électromagnétique intense, la direction du moment

cinétique ne présente pas une distribution continue contrairement à ce que

laisse présumer le concept d'énergie. L’analyse de Fourier de l'équation de

Schrödinger a démontré que l'énergie des photons n’était émise ou absorbée qu'à

certains niveaux d'excitation des électrons. Ainsi pour une valeur précise de

l , le nombre quantique magnétique m ne peut prendre que certaines

valeurs : - l, - l + 1,..., 0,..., l -1, l. Chaque sous-couche est donc divisée

en cases quantiques définies par le nombre quantique magnétique, m qui

lui donne son orientation dans l'espace.

Mais

même en l'absence de champ magnétique, la plupart des raies spectrales ont une

structure fine formée de doublets très étroits. L'électron n'est donc pas

entièrement déterminé par ces trois nombres quantiques n, l et m.

Un quatrième nombre quantique vient s'ajouter pour déterminer le moment

cinétique propre de l'électron, c'est le moment angulaire de spin S où s

est le nombre quantique de spin :

S = √

[ s (s + 1)

]

]

Le

nombre quantique magnétique et le nombre de spin sont en corrélations et ne

peuvent prendre que deux orientations, l'une par rapport à l'autre suivant la

grandeur du moment angulaire S sur l'axe vertical. Si deux électrons sont sur la

même couche, ils auront un nombre de spin opposé (s = 1/2 ou -1/2), en rappelant

le principe d'exclusion de Pauli interdisant à deux électrons d'avoir les quatre

nombres quantiques égaux deux à deux. Si c'était le cas les particules

pourraient occuper n'importe quel état quantique et seraient indiscernables les

unes des autres, non identifiables à un instant donné. Pratiquement cela conduit

à rendre les couches les plus basses (k, l, m, ...) rapidement saturées avec

respectivement 2, 8 et 18 électrons, et ainsi de suite. Si le nombre de spin est

nul, cela signifie que la particule ne tourne pas, comme c’est le cas pour les

mésons.

Si

l'atome subit un excitation très forte, au deuxième état d'excitation l'électron

passera sur la troisième couche possible à 4.47 Å (32 x 0.53), etc.

Les couches se complexifient à mesure que l'énergie augmente et sont infinies,

délimitées par un "nuage d'indétermination" où l'on peut trouver l'électron.

Mais il existe une probabilité non nulle de trouver l'électron en dehors de la

matière suite à l'effet tunnel. Cette distance est toutefois limitée car cette

probabilité décroît rapidement à mesure que l'on s'éloigne de la matière. Au-delà

de quelques nanomètres l'atome ne peut plus retenir l'électron par sa force

électrostatique (coulombienne) et l'atome s'ionise. En

pratique quelques eV suffisent pour ioniser un atome.

Les

états excités des atomes sont transitoires. Le premier état d'excitation

persiste 10-8

sec. L'électron tente alors de retomber à un état de moindre énergie, plus

stable. Si l'atome est dans un état naturel excité au niveau 2, il "redescendra"

au niveau 2. Ce retour à l'état plus stable s'accompagne d'une libération

d'énergie (bremsstrahlung), d'une fréquence tributaire de l'étage d'excitation

duquel "chute" l'électron et du degré d'ionisation des atomes. Ce peut-être une

radiation du spectre visible, un rayonnement

a

ou X dans le cas d'une réaction nucléaire ou une radiation monochromatique laser

(optique) ou maser (radio) lorsqu'il s'agit de réactions atomiques. La durée du

phénomène est fonction de la quantité de matière et des niveaux de transitions

atomiques.

Le

rayonnement, induit dans le cas présent par les électrons, peut aussi apparaître

suite à une transition électronique entre deux sous-niveaux. La raie de

l'hydrogène à 21 cm par exemple (atome HI) correspond au changement de rotation

du proton (spin) suite à l'interaction avec le spin de l'électron. Cette

énergie ainsi libérée est inversement proportionnelle à la longueur d'onde, en

parfait accord avec la distribution des énergies de la formule de Planck. A de

très courtes longueurs d'ondes, la densité du rayonnement du corps noir devient

très faible mais les photons présentent un niveau d'énergie très élevé. Seule la

théorie quantique permet une telle affirmation qui ne peut être démontrée par

une théorie ondulatoire. Dans le cas de la lumière du Soleil, l'excitation est

tellement intense que tous les atomes sont le siège de transitions très variées,

donnant à sa lumière une coloration dite blanche, polychromatique. Son spectre

est continu (des raies d'absorption s'y superposent pour chaque élément présent

dans son atmosphère). Cette théorie quantique est confirmée expérimentalement

dans les accélérateurs de particules, les mesures radioastronomiques et la

spectroscopie et s'applique donc à la totalité du spectre électromagnétique.

La

spectroscopie

Entre-temps,

rappelons que du 30 octobre au 3 novembre 1911, le 1er Congrès Solvay fut organisé à Bruxelles, portant sur "la théorie du rayonnement et des quantas".

Toute l'élite de la science était présente et discuta pendant 4 jours de l'essor

de la nouvelle physique quantique. Einstein y fit une entrée timide mais il

était entouré des non moins célèbres Max Planck tout auréolé de la découverte

des quantas, Marie Curie, Maurice de Broglie, Paul Langevin, Jean Perrin, Henri

Poincaré, Ernest Rutherford, Wilhem Wien,... un parterre de 24 savants membres

du nouveau noyau dur de la physique. On y parla du corps noir et des quantas,

des atomes, des principes de la thermodynamique, du chaos, de relativité, autant

de concepts considérés avec méfiance par l'ancienne génération de savants.

|

La mécanique ondulatoire (I)

Face à la théorie de Heisenberg, un nouveau concept était en train de

naître. En 1924, le physicien français Louis de Broglie imagina que les

atomes pouvaient se comporter comme des ondes. Louis de Broglie fit une

synthèse géniale des lois quantiques et relativistes qui lui vaudra le

prix Nobel.

Les fréquences "quantiques" qui s'accordaient parfaitement avec la formule

de Nicholson-Bohr et la constante de Planck, n'obéissaient plus tout à

fait à la théorie classique de Bohr. |

|

Il

fallait donc modifier la théorie et étant donné que personne n'avait jamais

observé un électron sur son orbitale, Louis de Broglie se demanda pourquoi ne

pas en arriver à une modification radicale du concept atomique... Il était un

fait que ce que nous savions de certains atomes était uniquement lié aux raies

spectrales et à leur intensité...

Ayant

parfaitement maîtrisé les travaux d'Einstein, Louis de Broglie considéra que la

lumière, avec ses propriétés ondulatoires était constituée de photons (et leur

attribua avec erreur une masse). Sachant qu'il existait une relation entre

l'énergie des particules et la fréquence de leurs rayonnements, de Broglie

inventa la “mécanique ondulatoire”, faisant l’hypothèse qu’à toute particule de

masse m et de vitesse

v était associée une

onde de longueur d’onde

l

et de fréquence n

:

Son

hypothèse sera suivie par Léon Brillouin et Harry Bateman.

Si la représentation ondulatoire imaginée par de Broglie était correcte, il

était mathématiquement possible de créer les “harmoniques", les vibrations

multiples qui expliqueraient par exemple les raies de la série de Balmer émises

par l'hydrogène.

Dans le

cadre d'une théorie ondulatoire cette idée semblait

idiote. A première vue,

une onde discontinue est un non-sens car sa réalité n'est pas formée d'unités

distinctes, sa grandeur ne variant pas par quantités entières, mais de façon

continue. Plusieurs exemples confirment néanmoins cette idée de "fonction d'onde".

Imaginons que nous représentons la trajectoire d'un électron par une corde de

violon en vibration. L'analyse de Fourier démontre que les ondes harmoniques

produites par cette corde en vibration ne sont formées que d'un nombre entier

d'ondes fondamentales. En attachant cette corde à l'une de ses extrémités, le

fait de la secouer provoque le déplacement d'une onde bien connue. Si vous

attachez ses deux extrémités, comme la corde du violon, l'onde qui

habituellement se propage se stabilise, produisant ce que l'on appelle une

onde stationnaire qui

ne peut vibrer qu'entre ses attaches, que l'on dénomme des noeuds.

Cette corde fermée représente les sarabandes sans fins de la trajectoire de

l'électron autour du noyau. En réalité, comme l'électron, l'onde se propage bien

mais est réfléchie lorsqu'elle arrive sur un noeud.

L'électron quant à lui continue ses sarabandes sans reconnaître le début de la

fin de sa trajectoire. La réflexion de l'onde sur un noeud annule certains

phases, forçant la corde à passer par un minimum et un maximum, rendant

invisible l'onde de propagation habituelle. En d'autres termes, l'onde se

propage par fraction entière :

ln

= 2l/n.

On peut

également démontrer ce phénomène de résonances avec un tuyau d'orgue. Dans le

mode dit "fondamental" la longueur d'onde du son vaut quatre fois la longueur du

tuyau. Son amplitude est maximale à l'extrémité ouverte. La longueur d'onde peut

donc varier de façon non continue, interdisant certaines grandeurs. Nous

retrouvons ce phénomène dans le spectre de l'hydrogène qui affiche les raies de

la série de Balmer à certains endroits et nul part ailleurs.

|

L'interprétation

probabiliste (II)

Grâce aux lois de la mécanique classique, nous savons que la trajectoire

d'une particule peut être parfaitement déterminée par trois paramètres, sa

position (q),

sa masse (m) et

sa vitesse (v),

le produit de ces deux dernières quantités représentant la quantité de

mouvement ou impulsion (p).

Lorsque Schrödinger remplaça les particules par des ondes pour expliquer

le spectre des atomes, son équation souleva quelques difficultés. |

|

La

première d’entre elles était que son équation était en contradiction avec la

mécanique quantique. S'il y avait deux électrons, il y avait deux équations et

12 dimensions, ce qui ne reflétait aucune réalité. Nous avons vu comment Born

résolu ce problème. En fait disait-il, la fonction d'onde de Schrödinger décrit

la probabilité

d'observer un électron ou une autre particule à un endroit. Les scientifiques se

rendirent alors compte que cette fonction d'onde

Y

décrivait quelque chose de bien plus subtil; les trajectoires devenaient des

nuages probabilistes.

Ainsi

que l’apprenne aujourd’hui tous les étudiants, cela signifie concrètement que

notre chance de localiser une particule n’est jamais égale à 100% dans le monde

quantique. Nous pouvons avoir 3 chances sur 4 de trouver l'électron là où nous

l'avons calculé mais nous ne pouvons pas en être certain. Comme le rappela

Heisenberg,

"la fonction d'onde représente précisément le possible et non

pas le réel ". Seule certitude, en moyenne, sur

base d'un calcul statistique trois fois sur quatre l'électron se trouvera bien

au rendez-vous des sommets des amplitudes maximales (des crêtes). Cela nous

permet de calculer le niveau d'énergie des atomes pour déterminer leurs

propriétés, la longueur d'onde des raies qu'ils émettront par exemple.

Deuxième difficulté, le problème de la localisation d'une particule, encore

relativement simple à résoudre si l'on travaille avec quelques particules, se

complexifie dans un milieu gazeux qui contient des milliards de particules,

chacune étant dans une orientation et un état de vibration particuliers. Les

dimensions du système tendent vers l'infini

tout comme la structure mathématique de l’espace vectoriel correspondant. Les

physiciens doivent travailler par approximation, encore faut-il connaître cette

formule approximative, ou user d'une méthode statistique pour déterminer la

position, la vitesse et la masse d'une particule isolée.

Les

physiciens comprirent que s’ils désiraient évaluer la probabilité qu'une

particule se comporte d'une manière ou d'une autre, ils devaient répéter

l’événement un nombre suffisant de fois. En faisant évoluer rapidement les

fonctions d'ondes, la probabilité tend à faire disparaître tous les états

possibles, sauf un, celui dans lequel se trouve la particule.

En ce

qui concerne l'électron, on parle de nuage orbital, d'orbites probabilistes

plutôt que d'une trajectoire qui obéissent à l'équation de Schrödinger. A partir

de l'instant où la position de la particule est localisée, la probabilité est

levée, et comme le dit Heisenberg il a “effondrement” ou "réduction du paquet

d'ondes". La grandeur n'a donc de réalité en mécanique quantique que si

l'événement peut-être vérifié par de nombreuses mesures.

En

septembre 1926, Bohr invita Schrödinger à Copenhague mais tous deux restèrent

inflexibles sur l'interprétation de la nouvelle théorie. Aux yeux de Bohr, la

théorie ondulatoire, de caractère continu était incompatible avec le phénomène

discontinu que représentaient les "sauts quantiques". Pour Schrödinger

l'interprétation probabiliste était irréaliste. Dans son esprit, l'atome devait

être conçu comme un tout, une "vibration universelle" car sa fonction d'onde

contenait toutes les informations de la particule. Il croyait à la philosophie hindou : "tout

est dans tout". En fait Bohr et Schrödinger n'interprétaient pas les résultats

expérimentaux de la même façon. Il faudra attendre une année pour réconcilier

les deux physiciens. Dans une certaine mesure cette controverse subsiste encore

aujourd'hui.

L’antimatière (III)

Poursuivant ses recherches, Schrödinger découvrit une formule qui s'adaptait aux

particules se propageant à faible vitesse, formule quantique qui portera son

nom, mais qui ne tenait pas compte de la théorie de la relativité. La fonction

d'onde se caractérise par deux variables : sa position

r au temps t. La

fonction d'onde n'est valable que si l'énergie totale

E de cette particule se définit

par sa quantité de mouvement p

(sa vitesse multiplié par sa masse), dans les limites ou le

rapport v/c est très petit, selon l'approximation:

qui

s'écrit aussi :

La

relation de Louis de Broglie peut alors subir une deuxième lecture. Une

particule peut être décrite en fonction de son énergie et de son impulsion. Ces

quantités étant reprises au dénominateur, il s'ensuit que si l'on veut sonder

les soubassements de la matière, à mesure que la distance s'amenuise les

quantités d'énergie et d'impulsion à mettre en jeu seront de plus en plus

importantes, d'où la construction d'accélérateurs de particules toujours plus

puissants.

En 1930

le physicien anglais Paul Dirac proposera une équation relativiste équivalente (théorie

de l'électrodynamique quantique, EDQ) qu'il déduira de la formule quantique de

Nicholson-Bohr et de l'équation d'équivalence d'Einstein, E = mc2.

Si la vitesse de la particule est élevée, l'approximation précédente devient :

E2 = m2c4

+ p2c2

Si v = 0, E =

±

√m2

Mais

l'équation de Dirac cache une subtilité. Si la masse de la particule est

négative, l'équation est tout de même vérifiée. Cela signifie qu'une particule

peut présenter un état d'énergie négatif.

Le

passage de l'état excité au niveau fondamental laisse apparaître une transition

d'énergie valant 2m, un saut de +m à -m. Cette discontinuité est absurde en

physique classique. Mais rétorque sa variante quantique, ce comportement est

tout à fait normal ! Dirac considéra que rien n'empêchait une particule de

sauter cette barrière d'énergie pour se retrouver dans un état négatif. Mais si

le phénomène existait, pourquoi toutes les particules - et en particulier les

électrons - ne tombaient-ils pas vers les énergies les plus basses qui tendent

vers moins l'infini ?

Pour

expliquer ce phénomène, Dirac conclu que les états d'énergie négatifs étaient

tous saturés de particules virtuelles.

Si ces particules virtuelles recevaient une énergie 2m (en émettant des

photons), elles basculeraient dans la réalité en laissant un "trou" négatif dans

le monde virtuel. Ce déséquilibre serait considéré comme un surplus d'énergie

positive. Dirac cru d'abord qu'il s'agissait du proton, seule particule positive

connue à l'époque, mais elle devait avoir la même masse que l'électron. Cette

charge positive nouvellement crée sera appelée

positron ou

antiélectron. Ainsi naquit l'antimatière

à la plus grande joie des auteurs de science-fiction.

Bien

que très déroutante, sa théorie sera confirmée au Caltech en décembre 1932 par

les physiciens Carl Anderson et Patrick Blackett qui détectèrent le positron

dans les rayons cosmiques. Depuis, la quasi totalité des particules ont trouvé

leur opposé y compris les particules neutres..

Principe d’exclusion et statistique de Fermi-Dirac

Après

cette découverte Wolfgang Paulise pencha sur les propriétés de la matière ou du rayonnement. La question était

de savoir pourquoi la lumière pouvait se mélanger à un autre faisceau lumineux

ou vibrer en cohérence alors qu’il était impossible de fusionner deux blocs de

matière.

En 1935

Pauli énonça le "principe d'exclusion". Pour empêcher expliqua-t-il, deux

fermions (toutes les particules sauf les bosons) d'occuper le même état

d'énergie, ceux-ci ne peuvent avoir la même combinaison des quatre nombres

quantiques pris 2 à 2, qu'il s'agisse du niveau d'énergie, du spin, du moment

angulaire, etc. Si cela pouvait se produire, les électrons des différentes

couches "chuteraient" sur le noyau et deviendraient indiscernables; c'est la

statistique de Fermi-Dirac. C’est l’action de ce principe et la structure du

noyau qui donne sa consistance à la matière.

A suivre!

Retour à la table des matières de

physique